Pourquoi c’est dangereux de trop en dire à ChatGPT

Quels sont les avantages et les inconvénients d’utiliser l’intelligence artificielle de ChatGPT pour produire son contenu? Est-ce que l’on devrait se méfier de ce qu’on lui donne comme informations sensibles? Malheureusement, la réponse est oui, puisque ChatGPT apprend et retient les données qu’on lui partage et les répète à qui veut bien l’entendre.

Pour certaines choses, ChatGPT et son intelligence artificielle sont vraiment super, si bien que certains employés l’utilisent carrément comme un assistant de production de contenu.

Rapports stratégiques, présentations PowerPoint… Honnêtement, avec les bonnes informations, c’est vraiment impressionnant ce que la machine réussit à créer.

Par contre, le hic est là: les gens oublient parfois que l’intelligence artificielle derrière ChatGPT, ce n’est qu’un ordinateur qui apprend des informations, les intègre, les interprète et… les repartage.

Des données sensibles réutilisées dans les réponses de ChatGPT

Selon une étude de la société de cybersécurité Cyberhaven publiée en février 2023, ce sont plusieurs dizaines de milliers d’employés qui auraient transmis des données d’entreprises à ChatGPT.

Même si à la base ceux-ci ne le font pas avec de mauvaises intentions, ChatGPT conserve et apprend de cesdites données.

Dans certains cas, l’outil web va même jusqu’à générer des réponses à des questions basées aux données internes divulguées par un employé voulant créer du contenu.

Les cas se sont avérés tellement sérieux que plusieurs multinationales se sont mises à complètement interdire l’utilisation de l’outil dans un cadre professionnel.

Même Microsoft, qui investit tellement dans le projet ChatGPT qu’il l’a ajouté à son moteur de recherche Bing, a demandé à ses employés de ne jamais partager d’informations sensibles concernant l’entreprise à l’intelligence artificielle.

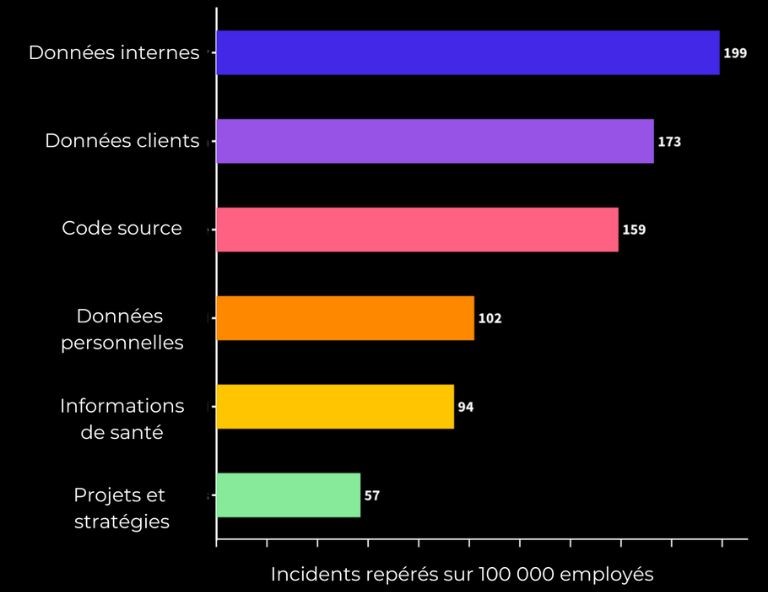

De manière plus précise, l’étude de Cyberhaven a montré que sur 100 000 employés:

- 200 personnes ont partagé des données internes;

- 173 employés ont donné des données clients;

- Du code source a été partagé par 159 personnes;

- Près de 200 personnes ont donné des données personnelles et des informations de santé.

Un aperçu des données récoltées dans l’étude de Cyberhaven. Source: Numerama et Cyberhaven.

Bref, oui on peut utiliser ChatGPT pour produire des documents et des rapports, mais aucune information sensible ne devrait être mise dans la machine parce que celles-ci contribuent à alimenter son intelligence.

À moins que vous souhaitiez que ChatGPT révèle votre code source à une entreprise adverse qui lui demande de rectifier son code, je m’abstiendrais complètement de lui donner!